ChatGPT поставил правильный диагноз там, где не справились 17 врачей

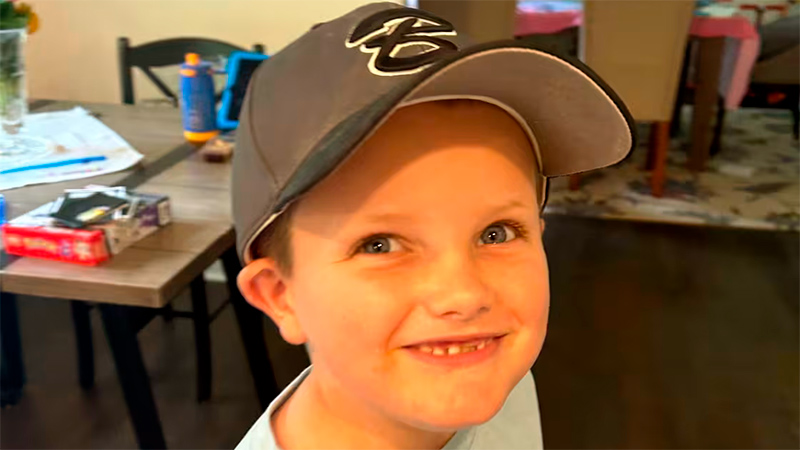

Юный Алекс, которому 17 врачей не смогли поставить правильный диагноз

Юный Алекс, которому 17 врачей не смогли поставить правильный диагноз

Показательную историю рассказала в издании Today женщина, которую зовут Кортни.

С 2021 года ее 4-летний сын по имени Алекс начал испытывать различные боли. Няня ребенка сказала Кортни, что она вынуждена время от времени давать ребенку Motrin (ибупрофен), чтобы избавить его от боли и соответствующих срывов.

Ребенок явно страдал, вел себя очень странно, закатывал истерики, периодически начинал грызть предметы. Родители водили его по врачам. В какой-то момент его обследовал ортодонт (у родителей было подозрение, что ребенок плохо спит, из-за чего выглядит измученным), и ортодонт обнаружил определенные проблемы с нёбом у ребенка. Ему поставили на нёбо специальный расширитель, и на какое-то время ситуация заметно улучшилась.

Потом Кортни заметила, что Алекс перестал расти, что у него наблюдается дисбаланс между правой и левой стороной тела, также он стал испытывать сильные головные боли.

Алекса водили к педиатрам, узким специалистам: всего за 3 года они посетили 17 врачей и провели множество обследований, но никто из них так и не смог поставить диагноз, который бы объяснял все симптомы.

И тогда уже отчаявшаяся Кортни зарегистрировалась в ChatGPT и ввела там всю информацию об обследованиях и все симптомы.

ChatGPT высказал предположение о том, что это может быть синдром перетянутого позвоночника. Кортни нашла в Facebook группу, объединяющую семьи детей с этим синдромом, и их истории были похожи на историю Алекса. Тогда они пошли к новому нейрохирургу, и Кортни сказала, что подозревает у сына наличие этого синдрома. Доктор посмотрела снимки МРТ и сказала, что диагноз совершенно правильный: она на снимке увидела occulta spina bifida (осколочный спинальный дефект) и перетянутый позвоночник.

По данным Американской ассоциации неврологических хирургов, синдром перетянутого позвоночника возникает, когда ткани спинного мозга образуют крепления, ограничивающие подвижность спинного мозга, вызывая его ненормальное растяжение. Это состояние тесно связано со spina bifida - врожденным дефектом, при котором часть спинного мозга развивается не полностью, и некоторые участки спинного мозга и нервов оказываются оголенными.

При синдроме переплетения спинного мозга "спинной мозг к чему-то прилипает". Это может быть опухоль в спинномозговом канале. Это может быть шишка на костном шипе. Это может быть просто слишком много жира на конце спинного мозга", - рассказывает TODAY.com доктор Холли Гилмер, детский нейрохирург из Мичиганского института головы и позвоночника, который лечил Алекса.

У многих детей со spina bifida есть видимое отверстие в спине. Но у Алекса оно закрыто и считается "скрытым", также известным как spina bifida occulta, согласно данным Центров по контролю и профилактике заболеваний США.

После получения правильного диагноза Алекс перенес операцию по устранению этого синдрома, и теперь он, по словам Кортни, быстро восстанавливается.

Специалисты признают, что в определенных случаях ChatGPT может поставить диагноз точнее, чем соответствующий специалист, потому что он оперирует с огромными объемами информации, и у него нет "слепых зон", как у врача-человека.

Однако следует иметь в виду, что ChatGPT иногда может фабриковать какую-то информацию, если не может найти правильный ответ, и тогда диагноз будет поставлен неправильно.

Но в любом случае специалисты считают, что использование систем искусственного интеллекта в диагностике имеет большие перспективы.

Разумеется, система сама не ставит диагноз - а только показывает найденные изменения на отключаемом слое (на манер карт), но это очень помогает врачу в оценке действия назначенных методов лечения - например, при онкологии.

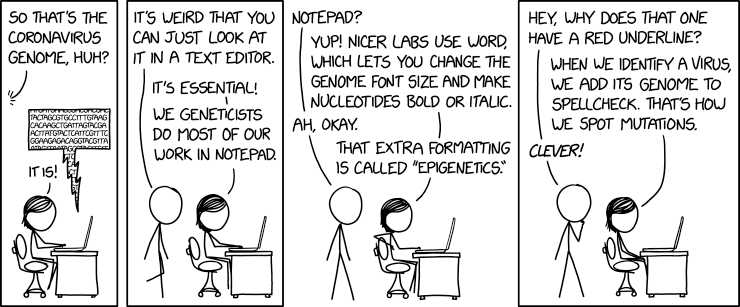

Последовательности сравниваются в БЛАСТе, форматирует в плейн-тексте, главное выставлять fixed-size фонт.

В бытовой же ситуации, обычный челвек даже описать свои симптомы корректно не сможет. С такими входными данными и результат работы нейросетки будет соответсвующим. Основная работа врача диагноста - задать пациенту правильные вопросы и отсеить неправильные ответы.

- Пациент, что у вас болит?

- Голова, доктор.

- Ответ неверный! Повторяю вопрос - что у вас болит?

Знавал я одного такого доктора, он имел довольно странную привычку не верить в то, что пациенты ему говорят. Наверное, это был прирожденный диагност!

- Пациент, что у вас голова болит?

- Да доктор, но только если в вечера больше литра выпил. Или если жена скалкой ударили. А вот колено каждое утро скрипит! А еще у Машки соседский триппер три года назад нашли, возможно это как-то связано.

Лечение назначает врач, анализы тоже делаются по его предписанию.

И тогда уже отчаявшаяся Кортни зарегистрировалась в ChatGPT и ввела там всю информацию об обследованиях и все симптомы.

Неизвестно, обратись Кортни к 18-ому врачу вместо ChatGPT, сумел бы он поставить (предположить) верный диагноз.

Также неизвестно, не обратись Кортни к 17-ому врачу, сумел бы ChatGPT на основе исследований только от 16 врачей поставить ровно тот же диагноз.

Но как минимум, он оказался не хуже гипотетического 18-го врача, что позволяет с осторожным оптимизмом и тайной надеждой смотреть в грядущее!

Похоже, верный способ выпилить кожанных мешков с этой планеты таки найден.

Думаю, скоро увидим, превратится ли это в полноценный иструмент диагностики или останется на уровне казуса. Так-то выглядит многообещающе.

Черт, я так гордился своим красивым комментарием, а вы все испортили!

— Доктор, каковы шансы на успех?

— Я думаю, всё будет хорошо!

— А сколько вы уже сделали подобных операций?

— Пятьдесят.

— И все они были удачными?

— Нет. Все оказались неудачными.

— Так как же вы можете говорить, что всё будет хорошо?!

— Ну, когда-то уже должно в конце концов получиться.

Давным давно в больнице на соседней койке лежал мальчик которого долго лечили от эпилепсии, а потом сделали КТ и оказалась опухоль в мозге. КТ в те времена было редкость в СССР.

В комментах ниже говорят, что

"можно поставить диагноз и проверить, подходит диагноз или совсем мимо. Если подходит, практически всегда есть специфическое обследование и анализы, проверяем на них. Не совпало - ищем дальше."

Тут скорее всего дело не в том, что врачи не могли сами поставить диагноз, а в желании, в ответственности и в человеческом факторе.

Какая ответственность у ChatGPT за неправильный диагноз? Полный ноль, вообще никакой ответственности. А у врачей ответственность есть, и может вообще ну его нафиг все эти диагнозы и обследования, дома футбол, жена и котлеты.

И еще может просто физически нет времени, типа а фиг его знает- следующий!

Даже могут что-то из лечения назначить, которое само собой не помогает. А потом еще одно. Вот только результата почему-то нет.

-скрытая spina bifida (расщепление позвоночника) и синдром фиксированного спинного мозга.

то, что врач делает в голове (поиск совпадений по симптомам, поиск аналогичных случаев и т.д ) - эта задача, мне кажется лучше будет выполняться именно в автоматизированном виде, уж точно полнее, чем врачом...

ChatGPT это не интерфейс базы данных.

Никто в развитой стране с доказательной медициной не запихнёт пациента просто так в условный МРТ - слишком дорого.

Если в "методичке" будет прописано - запихните в МРТ, то запихнут. А так нет.

Только вот такая система хорошо работает на больших числах, на статистике.

А отдельному пациенту может и не повезти.

Похожие проблемы были -- с постановкой диагноза и лечением. Приходилось самому лезть в статьи и врачам (аккуратно и вежливо, чтобы, не дай бог, не задеть их самомнение) предлагать анализы, диагноз, и лечение. При этом думал, какого должно быть несчастным людям, у которых нет биохмического образования. Или вообще никакого образования. Наверное, к гомеопатам идут.

Потом я задал ему этот же вопрос, но только с другим вариантом решения, с другой стороны. Он выдал другое число, на этот раз уже правильное.

Я спросил, а как же так, что на одну и ту же задачу у него 2 разных ответа? Он просто извинился и всё.

Я это к чему. Все эти рассказки про то, что ChatGPT кому-то там что-то правильно рассказал- это всё ни о чём, во всяком случае пока. Потому что на один такой удачный случай есть очень много неудачных.

Если пока что ChatGPT не может с первого раза вычислить простую формулу из трёх чисел, то вы доверяете ему в таком несравненно сложном деле, как постановка диагноза, где переменных несравнимо больше?

LLM - они вообще не о том, а о том, чтобы предсказать следующий наиболее вероятный token в последовательности.

В смысле что испробовали все возможные варианты и уже не знали что дальше предпринять, или в смысле что просто не делали что можно было сделать и предпочли не ставить диагноз и не продолжать искать варианты?

То, что с диагностикой у врачей беда, это и не секрет, увы.

В свое время 6 лет в Англии не мог получить дорогой драг стандартным путем (NHS, i.e. public insurance). Транскрипт из Америки, где давали дорогой драг, английские NHS-доктора не признавали. Потом, когда совсем приперло (не мог работать), заплатил 500 фунтов за частную консультацию и тесты и получил драг через месяц.

Но я считаю это правильным! Всегда можно ошибиться, недоглядеть, не заметить. Следующий врач не может безоглядно полагаться на добросовестность и квалифицированность предыдущего — может боком выйти. Да и пациенту лучше. Известно же, что надёжнее всего проверять и перепроверять. Уж вам-то, учоному, это должно быть известно.

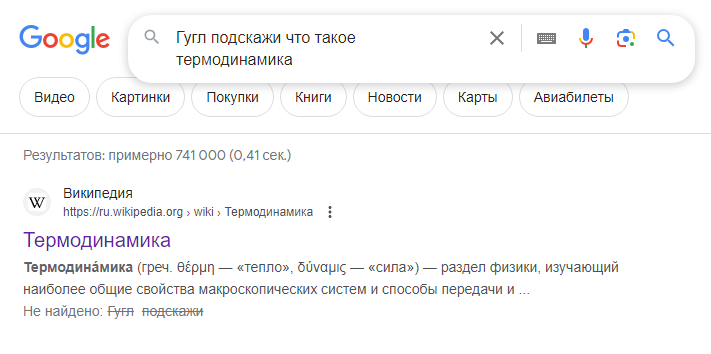

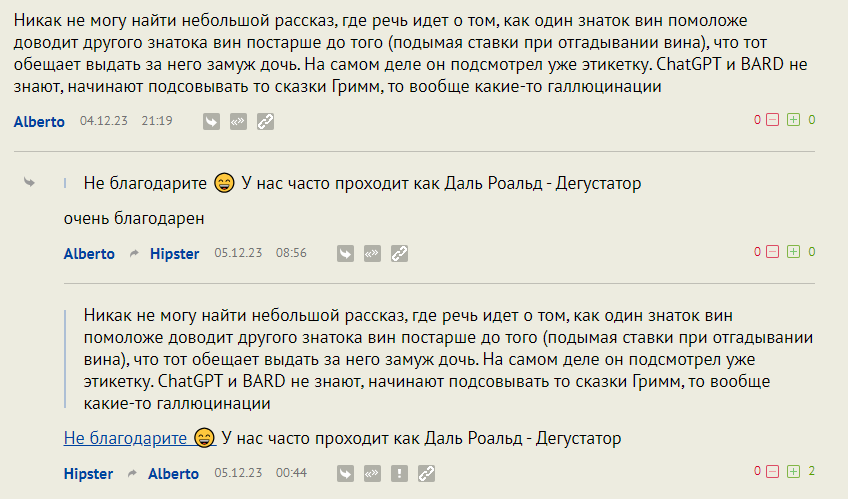

Я пыталась вспомнить название книги вроде как Куприна о том, как гимназисты били друг друга. (да, я признаю, что предельно тупо сформулировала вопрос, да и простой просмотр списка произведений авторства Куприна мне бы сразу дал ответ, но уж как есть, так есть).

После ответов, выданных ChatGPT, он у меня только для написания писем и постов в соцсети.

Но да, автор был отгадан сразу.

Возможно, вы имеете в виду роман Александра Куприна под названием "Дети Арбата". В этой книге описывается жизнь московских гимназистов в конце XIX - начале XX века, в том числе их взаимоотношения, конфликты и даже дуэли. Однако, следует отметить, что главный акцент в романе делается не на физическом насилии, а на внутреннем мире персонажей. Если это не тот текст, который вы имеете в виду, уточните дополнительные детали, и я постараюсь помочь вам найти нужное произведение.

Такая книга, вероятно, может быть "Дни Турбиных" Александра Тургенева. В этой книге описываются события в российской гимназии в конце 19 века, где школьники участвуют в различных конфликтах и дуэлях.

Кажется, вы описываете книгу "Молодые годы князя Нежинского" Михаила Салтыкова-Щедрина. Это произведение входит в цикл "Сказки старого дуба" и рассказывает о жизни гимназистов в царской России, включая описания столкновений и драк между ними.

Кажется, вы описываете книгу "Азазель" Михаила Булгакова. В этой книге описана история гимназистов в царское время, которые играли в опасную игру под названием "Азазель". Игра заключается в том, чтобы ударить друг друга в лицо. Пожалуйста, уточните, если вы имеете в виду другую книгу.

Кажется, вы описываете книгу "Обыкновенное чудо" (или "Чудеса обыкновенные") Максима Горького. В этой книге описывается жизнь студентов гимназии в царской России, и одним из эпизодов является схватка гимназистов во время конфликта.

Возможно, вы имеете в виду книгу "Детство" Льва Толстого. В этом произведении описывается детство и юность главного героя, Николая Ильича Неклюдова, в гимназии. В романе есть сцены, где рассказывается о различных аспектах жизни гимназистов, включая их взаимоотношения и даже драки. Однако, если вы имеете в виду конкретную книгу или рассказ, уточните дополнительные детали, и я постараюсь вам помочь.

Возможно, вы имеете в виду книгу "Капитанская дочка" Александра Сергеевича Пушкина. В этом романе описаны сцены средневекового российского общества, включая гимназическую жизнь, дружбу и столкновения между учениками. Однако, важно отметить, что в реальности не все гимназисты в царское время били друг друга, и "Капитанская дочка" представляет собой художественное произведение, а не историческую документацию.

Могу предположить, что вы имеете в виду книгу "Золотой теленок" Ильи Ильфа и Евгения Петрова. В этой книге, написанной в стиле сатирической комедии, описываются различные аспекты жизни в Советском Союзе, включая сцены из школьной жизни. В одной из глав авторы описывают бойни между гимназистами в царскую эпоху.

Пуговицы - были, но их не рвали.

Кстати о пуговицах. Я тут как раз на днях подумала, что мои дети не то что пуговицы пришивать не умеют, они нитку в иголку не вставят. Потому, что не надо. Я не помню, когда последний раз пуговицы пришивала. И это при том, что у меня они ежедневно в школу в рубашках ходят.

Может, дети не такие агрессивные и не дерутся постоянно в школе? Как с этим в Англии?

Но мои ходят в чушпанскую школу в дорогом районе, так что откровенной гопоты у них нет. Но тут как-то средний попал в переплет, но в сравнении с тем "как это бывает" это был детский лепет. Мне кажется, они и драться-то толко не умеют. Даже не знаю, надо ли мне по этому поводу горевать. Хотя друг другу иногда могут залепить затрещину в порыве братской любви.

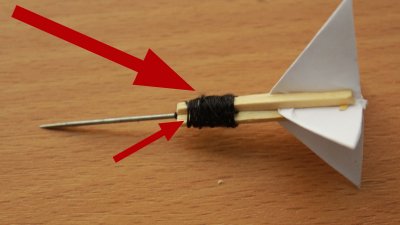

Согласен, штука суровая и опасная. Но вашего варианта я из описания не понял. Не могли бы вы привести рабочие чертежи?

А в качестве помощника при постановке диагноза он может быть весьма полезен, особенно в случае редких или экзотических болезней или синдромов.

Потому что Excel тоже написала Microsoft и Excel можно внутри Windows запустить.

Упрощу пример:

Судя по почерку Петя и Маша - левши.

Надеюсь теперь не нужно пояснять, что упоминание почерка в равной степени относится к обоим субьектам, а не только к одному.

В данном случае "И" это объединение, а не пересечение.

Мы же не теорией множеств тут занимаемся, а просто комменты строчим.

Все гораздо проще:

- становитесь в угол девочки и мальчики.

Очевидно, что не ожидается увидеть в углу редких представителей истинного гермафродитизма.

И у jbroid комменты.

И у прочих представителей комменты.

А не как вы пытались перенести "комменты" (рисунки, то бишь) только на "прочих".

LLM может генерить безобидный текст на основании модели и дополнительных вводных данных. А вот так называемая агенты могут подсунуть вопрос о генерации кода на любом языке, скомпилировать и выполнить его и результат отдать назад для дальнейшего обучения и совершенствования модели. И таких агентов может быть несколько, которые будут решать задачку параллельно и очень быстро и они скорее всего добьются цели при определенных условиях. А задача может быть любая: написание новой игрушки, приложения для сервера, проникновения в защищенную систему например банка, управление любым типом оружия с удаленным управлением, и т.д. Так что здравствуй Skynet!

Любая болезнь характеризуется определённым набором симптомов.

Зацените все это в базу данных и делайте поиск по ней. Очевидно же, что живой человек может не впомнить о какой-то редкой болезни. Вот база данных ему в помощь.

Upd. О! Пока печатал, frost умнее сказал.

Это ограничение и сейчас существует, без всякого ИИ. Тот же врач без микроскопа гистологическое исследование не проведет, однако парадоксом это не называют.

Вот, нашел. Правда это врач паталогоанатом, но подкаст именно об искусственном интеллекте в медицине, в том числе и онкологии

"Сначала врач проверит, подходит диагноз или совсем мимо. Если подходит, практически всегда есть специфическое обследование и анализы, проверяем на них. Не совпало - ищем дальше."

17 врачей не могли поставить диагноз и проверить правильный он или нет, а если нет, то идти дальше? Т.е. они выбрали просто вообще ничего не ставить.

За нестандартными решениями надо лезть и читать историю на 50 страниц, это невозможно сделать за 15 минут. Moжет, нужен ИИ, который может прочитать историю за врача и сделать короткое екзекютив саммари и обозначить, на основании данных, что стОит пробовать, а что уже опробовано.

Я поэтому и интересуюсь, а что мешает тоже самое сделать самим врачам, без этапа чатика?

И если, как вы говорите, врачи сами не знают какой из вариантов правильный, как они могут принимать во внимание какой-то вариант, который выдал фиг-пойми-какой-то ChatGPT?

Внедрение обсуждаемых ИИ позволит обеспечить Хаусами каждую больницу!

Я совсем не сведущ в ИИ-художествах. Здесь надо бы картинку, сращивающую Грегори Хауса с Чат ГПТ.